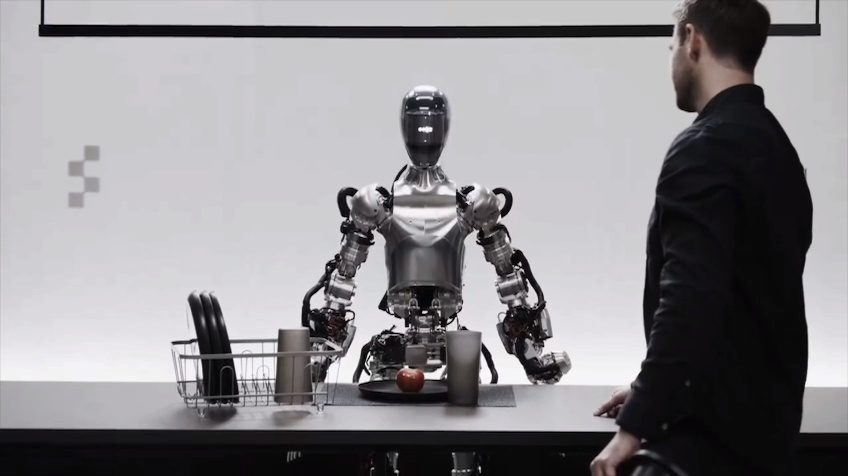

С помощью модели OpenAI робот обрабатывает визуальную информацию и распознаёт речь, а за его движения отвечают собственные нейросети Figure

Перевод ролика, который демонстрирует все умения робота Figure 01:

Мужчина: «Эй, Figure 01, что ты видишь прямо сейчас?»

Робот: «Я вижу красное яблоко на тарелке, которая стоит в центре стола. Тарелки и стакан в сушилке. А рядом стоишь ты, опираясь рукой на стол»

Мужчина: «Могу я что-то съесть?»

Робот: «Конечно». Берёт яблоко и даёт его мужчине в руки

Дальше мужчина высыпает на тарелку мусор и говорит: «Ты можешь объяснить то, что ты только что сделал, пока собираешь этот мусор?»

Робот: «Я дал тебе яблоко, потому что это единственный съедобный предмет, который я мог тебе дать». Во время ответа он кидает мусор в корзину, а затем двигает её в сторону мужчины

Мужчина: «Отлично, исходя из того, что происходит сейчас, куда стоит поставить посуду, которая стоит перед тобой?»

Робот: «Посуда на столе похожа на тарелки и стаканы, которые стоят в сушилке, поэтому скорее всего, она отправится в сушилку»

Мужчина: «Ты можешь её туда поставить?»

Робот: «Конечно», и ставит стакан и тарелку в сушилку

Мужчина: «Хорошо, как ты думаешь, ты справился?»

Робот: «Я думаю, что я отлично поработал: яблоко нашло нового владельца, мусор исчез, а на столе всё стоит на своём месте»

Мужчина: «Я согласен, спасибо, Figure 01»

Робот: «Всегда пожалуйста, если вам понадобится помощь, просто дайте мне знать»

Выводы делайте сами :-)

Обсуждение

Похожее

Бесплатный шрифт Monserrat получил кириллицу

Как продать 5000 работ нейросети

The Wizard of AI — видеоэссе о генеративном ИИ